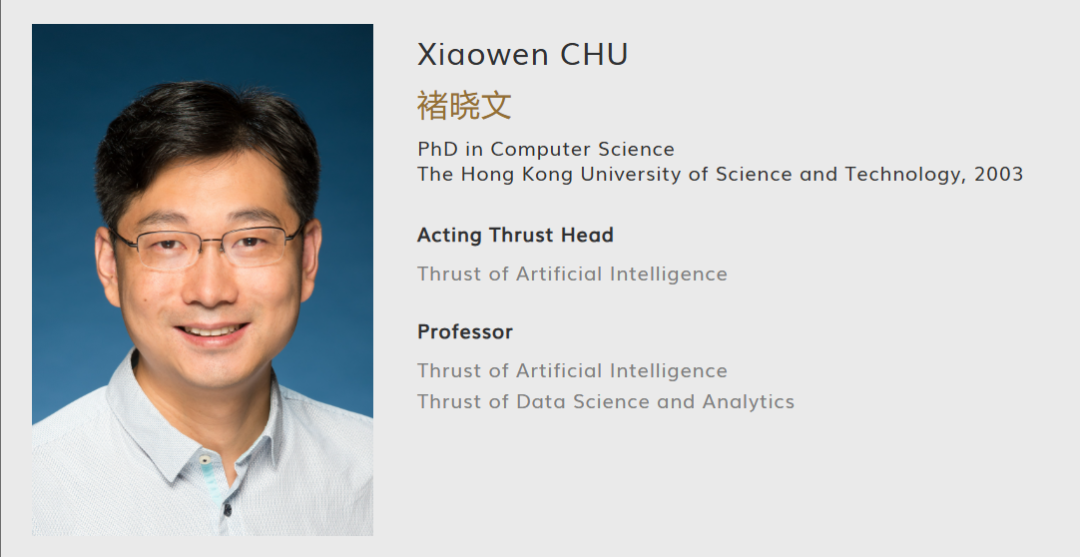

一、导师简介

Xiaowen Chu(褚晓文)现任香港科技大学(广州)信息枢纽数据科学与分析学域全职教授,同时担任人工智能学域代理主任。其学术轨迹呈现清晰的跨地域发展脉络:1999年获清华大学计算机科学与技术专业工学学士学位,2003年于香港科技大学取得博士学位,2003年至2021年间在香港浸会大学计算机科学系完成从助理教授到教授的完整晋升周期,2021年起转入港科大(广州)平台。

学术身份方面,Chu教授持有IEEE高级会员与ACM会员资格,并担任中国通信学会区块链专委会副主任委员。这种跨平台的学术任职反映其在分布式系统与可信计算领域的行业认可度。其研究版图可划分为四个象限:GPU计算建模与并行算法设计、分布式机器学习系统架构(涵盖联邦学习)、自动驾驶场景的计算机视觉应用、以及车联网通信协议优化。特别值得注意的是,Chu教授自2008年起持续深耕GPU计算,自2016年切入分布式机器学习,研究延续性超过十年,形成从硬件加速到算法部署的纵向贯通。

二、近期文章和项目解析

(一)大模型压缩与推理优化系列

2024至2025年间,Chu教授团队密集产出六项相关成果,构成完整的技术栈。

1. 训练后剪枝自动化:Pruner-Zero框架

该工作发表于ICML 2024,核心贡献在于将符号回归与进化算法引入剪枝指标搜索。传统剪枝依赖人工设计重要性指标(如权重幅值、梯度信息),Pruner-Zero通过遗传编程自动演化符号表达式,在LLaMA-2模型上实现稀疏度50%时精度损失低于3%。人工分析视角解读:此研究实质是将神经架构搜索(NAS)思想迁移至压缩领域,其突破性在于把"指标设计"从人类先验知识驱动转为算法自动发现。开源代码显示,搜索空间包含17种基础算子,种群多样性策略采用反向操作简化,这种设计哲学与AutoML领域著名的"零次学习"范式形成呼应,但应用于模型压缩属首次尝试。

2. 结构化二值化:STBLLM突破1位精度墙

ICLR 2025接收论文提出0.55位/权重的极端压缩方案。观察发现,传统二值网络中存在大量"可翻转权重"——即随机改变其符号不会显著影响输出。基于该现象,团队引入N:M稀疏模式与标准化重要性(SI)度量,实现非均匀结构化剪枝。在LLaMA-13B上的测试显示,Wikitext2困惑度达11.07,较BiLLM提升3倍。此工作的工程价值在于:通过双二值化残差近似保留显著权重信息,配合细粒度分组策略,将存储需求压缩至原模型的1/58,使百亿参数模型部署于边缘设备成为可能。

3. 稀疏感知推理引擎:SpInfer系统

EuroSys 2025论文揭示GPU底层稀疏计算优化路径。现有LLM推理框架(如vLLM)主要利用高层稀疏性(如注意力机制中的稀疏模式),SpInfer则挖掘指令级并行性,通过重构CUDA内核使非零元素计算密度提升40%。实验表明,在A100 GPU上运行SparseGPT剪枝后的OPT-66B模型,吞吐量较基线提高1.8倍。这反映Chu教授团队从算法压缩到系统实现的闭环思维。

(二)云边协同资源管理

4. 边缘AI协作系统:Galaxy架构

IEEE INFOCOM 2024工作针对Transformer模型在边缘设备的原位推理问题。传统方案采用模型分区或数据并行,Galaxy创新性地提出混合并行(HMP)与瓦片化通信。在1000Mbps带宽环境下,4块Jetson Nano-M板卡构成弱扩展配置,GPT2-L模型达到线性加速比的81%,强扩展下延迟降低3.05倍。关键设计在于:边缘节点仅加载单层而非完整模型,通过动态调度规避OOM错误。此研究回应了工业界"大模型边缘化"诉求,与华为、英伟达的边缘计算白皮书方向一致,但提供了可量化的系统原型。

5. GPU资源虚拟化:SGDRC控制器

PPoPP 2025论文解决数据中心多租户DNN推理的资源隔离难题。NVIDIA GPU的显存带宽分配接口未开放,SGDRC通过逆向工程揭示显存通道哈希映射规律,采用软件级缓存着色消除通道冲突。双模态张量与潮汐SM掩码机制实现计算单元与带宽的动态再分配。在Tesla V100与A100上的测试显示,高优先级任务SLO达成率99.0%,整体吞吐量提升1.47倍。人工分析视角:该工作属于"灰色盒"优化,不依赖硬件改造而是通过微架构行为建模实现精细控制,类似MIG(Multi-Instance GPU)但更具灵活性,对云计算厂商具有直接商业价值。

(三)自动驾驶安全框架

6. 显式碰撞约束:Risk-Aware Net

IEEE Robotics and Automation Letters 2024论文提出将安全风险纳入端到端驾驶模型。现有方法多通过后处理或奖励函数隐式约束碰撞,该框架直接在神经网络中嵌入碰撞概率层,通过可微分物理引擎实现梯度回传。实验在CARLA模拟器中进行,高风险场景下碰撞率降低62%。此研究体现Chu教授团队将分布式系统思维(风险感知)跨界应用于机器人领域的特点。

(四)在研项目深度解析

1. 广州市科技局项目:基于点对点的分布式大语言模型训练平台

该项目名称暗示采用去中心化拓扑,区别于主流的参数服务器或All-Reduce架构。点对点架构在异构网络环境下具有更好的容错性,但面临同步开销大、收敛性保障难等问题。结合Chu教授在区块链专委会的任职,可能融入去中心化共识机制,这在学术界尚属探索阶段。工业界类似尝试包括PyTorch的ElasticTrainer,但多为混合架构。此项目若成功,可为中小机构提供低成本大模型训练方案。

2. 香港大学合作项目:自动化分布式机器学习

项目名称强调"自动化",大概率延续Pruner-Zero的AutoML思路,扩展至并行策略搜索。当前分布式训练需人工配置并行度(tensor/pipeline/data parallel),自动化系统可根据模型结构与硬件拓扑自动求解最优策略。这需构建性能预测模型,属于元学习范畴。Chu教授2024年产出30篇论文的惊人效率,侧面印证其团队在自动化实验流程方面的技术积累。

三、未来研究预测

基于当前轨迹,Chu教授下一步可能朝三个方向延伸:

其一,压缩-系统协同设计。现有工作呈模块化特征:Pruner-Zero负责压缩,SpInfer负责推理,SGDRC负责资源调度。未来可能出现"压缩感知调度"或"调度引导压缩"的闭环框架,例如根据边缘节点实时负载动态调整STBLLM的N:M稀疏比例,实现精度-延迟在线权衡。

其二,大模型安全与可信。中国通信学会区块链专委会职务表明其对分布式信任机制的关注。联邦学习与大模型结合时,参数压缩可能泄露隐私,区块链可提供审计追踪。预期研究方向包括:抗投毒的联邦剪枝算法、可验证的稀疏模式共识、GPU机密计算环境下的零知识证明。

其三,自动驾驶系统级优化。当前Risk-Aware Net侧重算法创新,未来可能扩展至车路协同场景:Galaxy架构可改造为车群分布式推理,SGDRC资源管理思想可应用于车载计算平台多任务调度。车规级芯片(如NVIDIA Drive Orin)的GPU资源更受限,STBLLM的二值化技术具有直接迁移价值。