昨天在网上看到一个有意思的观点讨论:

机器人该不该“要脸”?

问题的编者是这么说的:有人认为“脸是人类交流的第一界面。我们天生通过面部表情建立信任、传递共情。没有表情的医疗机器人如何安抚焦躁的病人?没有神态的教师机器人如何激发学生的兴趣?‘脸’不是装饰,而是功能。

而另外一些人认为,“要脸”是本世纪最危险的 AI 拟人化陷阱!我们正在把工具包装成“同类”。孩子会对家教机器人产生依赖,老人会对护理机器人付出真情……当机器用一张脸获取人类最珍贵的情感联结,这本身就是最大的不道德。

联系到最近,小鹏的人形机器人 IRON 登上舞台,掀起了‘机器人要不要像人’的争论。很多人不竟要问:“我们恐惧的究竟是无脸的机器,还是被机器重新定义的人性?”

从功能设计角度看,“脸”堪称是人类历史上最早的 UI。在人机交互的世界里,最有效的沟通往往不是通过语言,而是通过表情。人类天生具备对面部信号的高敏感度:微笑代表友好,皱眉传达困惑,点头表示确认。机器人“有脸”,并非为了美观,而是为了被更快理解。

比如在医疗场景里,一个带有柔和表情的陪护机器人能安抚患者的紧张情绪,让治疗过程更顺利;在教育场景中,一个会微笑、点头的教学机器人能激发学生的兴趣,维持课堂的互动氛围。甚至在客服行业,表情识别与情绪反馈也是服务效率的关键变量。

“脸”在这些系统里,本质上是一种情感接口(emotional interface),它不是要让机器更像人,而是让人更容易与机器对话。

但同时,“脸”一旦出现,界限就开始模糊。机器的微笑不是心情,而是脚本;它的点头不是理解,而是模式识别的反馈。但人类的大脑并不在意这些差别。神经科学研究早已证明:我们对机器面孔的反应与对真人面孔几乎相同。也就是说,只要机器做出“像人”的表情,我们就会被激活出“共情”的反应。

这其实是一种“共情的欺骗”(empathic deception)。

它让我们误以为机器具备意图和感受,甚至值得被理解、被尊重、被喜欢。当 AI 连接模拟说出“我在这里陪你”的时候,哪怕我们明知道那是预设脚本,也会在某个瞬间感到真实的安慰。

关于“要不要脸”的争论,打开了更大的问题:当机器越来越像人,它到底在模仿什么?是外形?行为?还是性别?

如果说“机器人要不要脸”还只是设计伦理层面的抽象讨论,那么小鹏 IRON 的登场,则让这一议题以极具视觉冲击的方式落地。

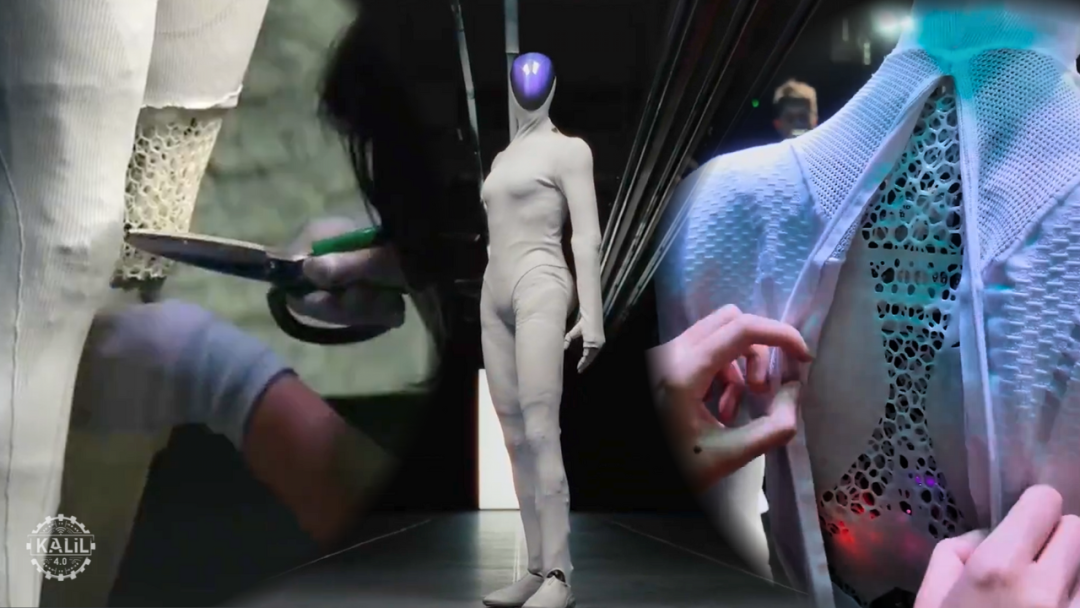

本月初的发布会上,这款人形机器人以极具视觉冲击力的猫步登台亮相:它的体态肩宽腰细、曲线明显、胸部造型突出。姿态之真,让“里面是不真的有个人”瞬间冲上热搜,逼得何小鹏给IRON“剖腹自证”。热度之高,引得一众自媒体博主从千奇百怪的角度“拆解”这款机器人。当中就包含了“好好的机器人,为啥要加个乳房”这样的问题。

网友们反应分化得出奇地鲜明。支持者认为 IRON 媲美“Tesla Optimus”,是中国机器人产业“拟人化程度最高”的代表;批评者则指出,这种造型在“炫技”之外,实际上是一种“性别化营销”。一张看似技术范的发布会舞台,成了性别想象的展示橱窗。

从传播逻辑看,这次亮相的成功之处,恰恰在于它的“人形感”。脸部的五官设计、身体的流线比例、甚至腰部转动的细微延迟,都在暗示着“更接近人”的幻觉。拟人化不再是功能需求,而是审美与商业的叠加产物:越“像人”,越能制造惊奇,越能在社交媒体上形成爆款。

账号“不客观实验室”的文章中对这场争议做了较为冷静的分析。它指出,IRON 胸部位置的隆起并非“有意性别化”,而可能出于工程设计考量。

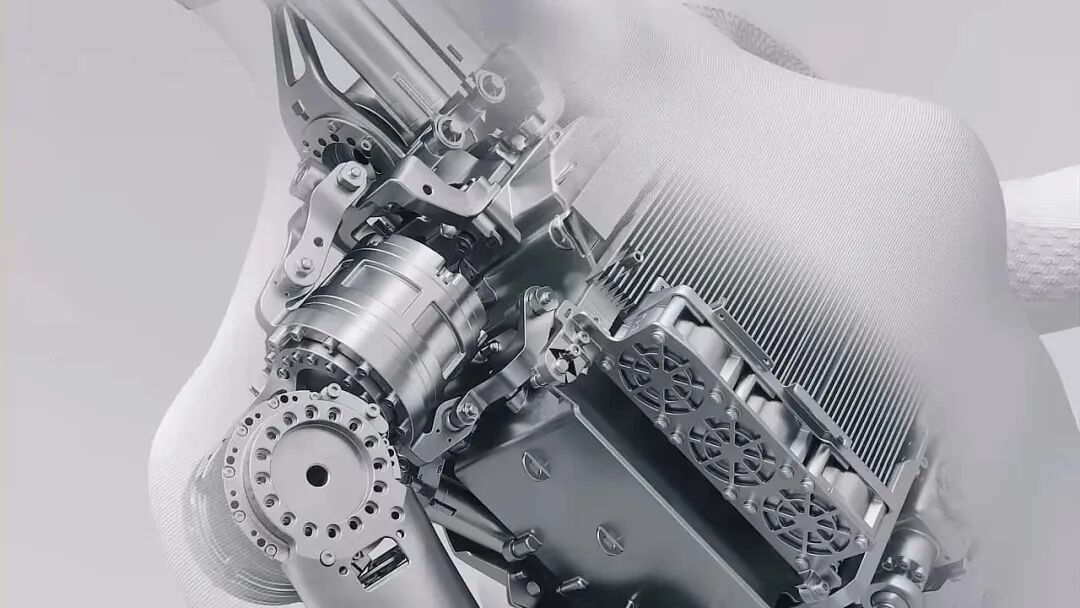

比如重心平衡:在人形机器人结构中,胸部区域常用于安放电池与主板模块,适当的前凸有助于重心稳定;散热空间:胸腔设计提供额外的气流通道,用于高功率计算单元的热交换;传感器布局:多维感知模块(如雷达、视觉、听觉传感器)集中分布于上躯干,外形的体积膨胀是结构妥协的结果……

这些解释无可厚非。但问题在于:当技术结果最终呈现出明确的性别符号时,它依然能被视为“中性技术”吗?

即使工程师的初衷纯粹是优化结构,视觉效果却在社会语境中被重新编码。一个“有胸”的机器人,被人眼瞬间读取为“女性”;而“女性形态”在商业传播中的利用,又难以与欲望、柔性、亲和等传统性别符号脱钩。技术逻辑与社会想象的叠加,使 IRON 不仅是一个机械体,更是一面镜子,照出了我们如何在算法的表面重演偏见。“胸部”在工程学上是散热腔,在文化上却成了象征载体;“曲线”在机械上是重心分布,在传播上却成了性别暗示。

技术可以中性,但设计从不中立。

“拟人化”赋予了机器情感外观,而“性别化”则让它拥有了社会角色。人类在塑造机器形体的同时,也在无意识地复制自己熟悉的社会结构。

当你唤醒手机里的 Siri 让它设闹钟开导航,回应你的女声永远语调柔和、反应迅速,永远没有疲惫、也不会拒绝。即使在机械形态中,这种性别倾向也依然存在:护理机器人被塑造成“女性照顾者”,安保机器人却多半是“男性守卫者”。技术语言的默认设置,以一种微妙而强大的方式,将社会对性别的期待重新编码进算法之中。

这正是很多学者所说的“算法性别化”(algorithmic gendering):当机器以性别化的外表、声音或行为与人类互动时,它不仅在模拟人类,也在再生产性别秩序,在用硅和代码延续“温柔的她”“强壮的他”这一文化脚本。

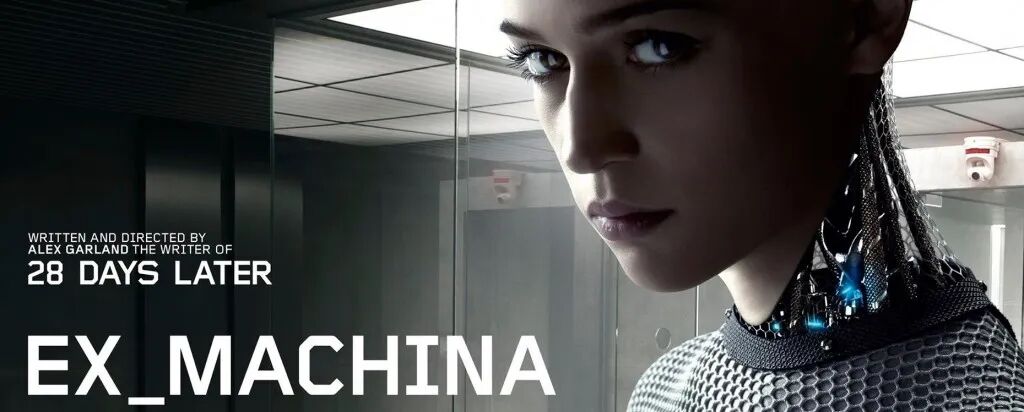

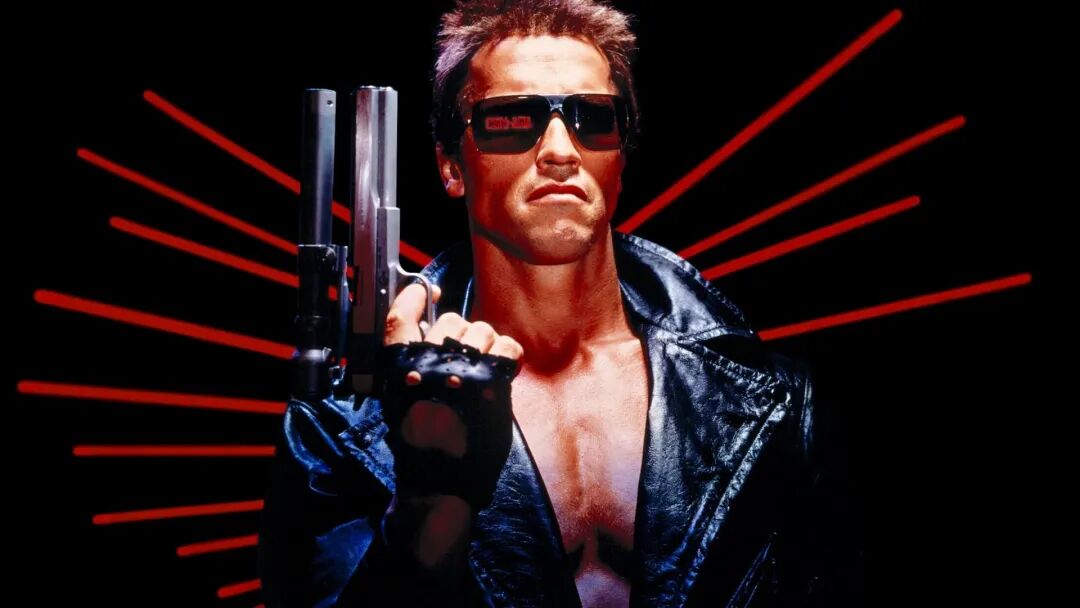

回看那些被赋予性别的机器人形象,从“机械姬”到“终结者”,无一不带着现实社会的隐喻。女性机器人往往被设定为照顾者、服务者、伴侣;男性机器人则象征力量、理性、保护。

这当然不是巧合,而是一种深层的“编码偏见”:在人工智能的语料与模型中,性别角色被当作可量化的模式被训练、提炼、再现。AI 不只是学习了人类的语言,也学习了人类对“谁应该温柔”“谁应该听话”的想象。于是技术成为了社会结构的复印机:每一个“听话的女声”背后,都是历史上被期待听话的女性角色;每一个“力量型男性机器人”,都在呼应着旧有的权力逻辑。

早在上世纪八十年代,Donna Haraway 就在《赛博格宣言》A Cyborg Manifesto:中提出,“赛博格”(cyborg)应当超越性别、物种与身份的界限,是一种“后人类的混合存在”。但现实的发展方向却恰恰相反:

我们没有创造出“无性别的智能”,反而在机器身上重新塑造了“性别化的人”。

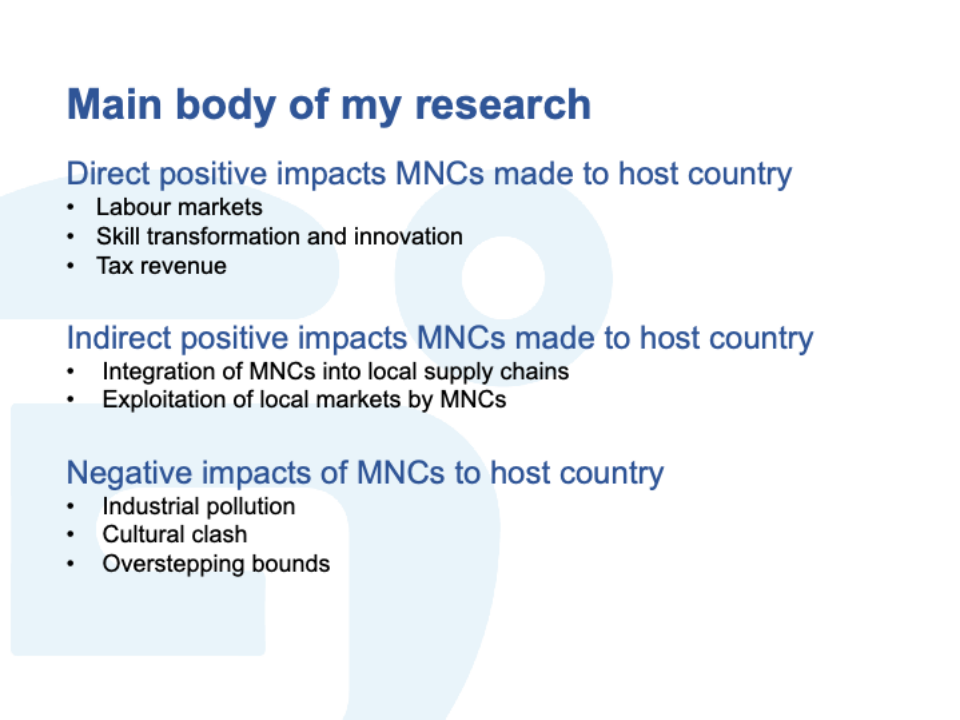

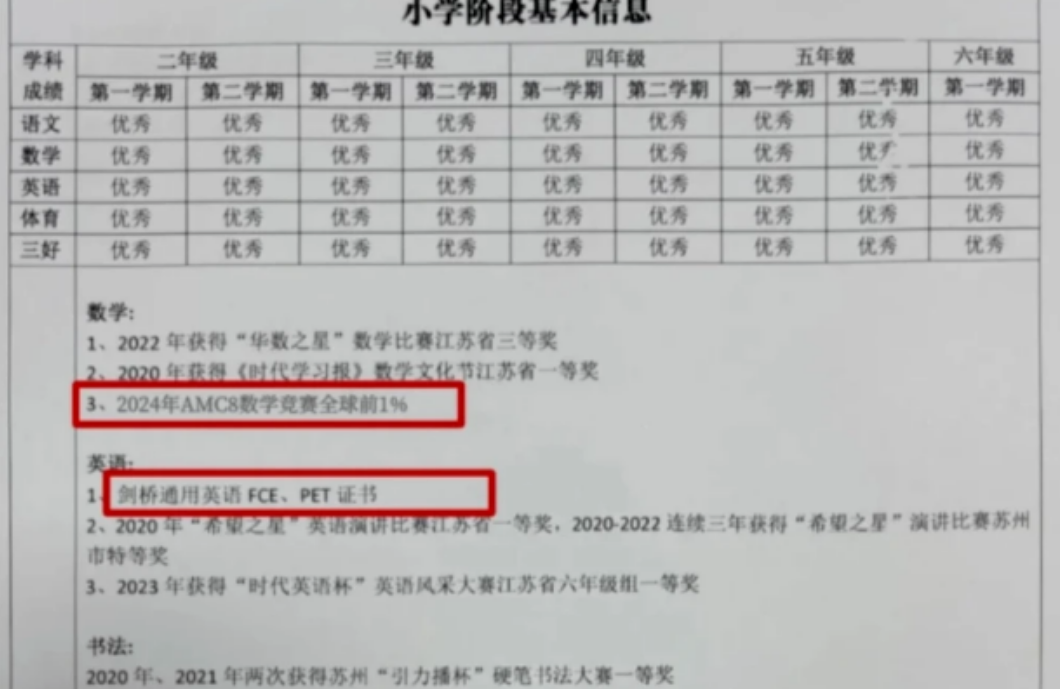

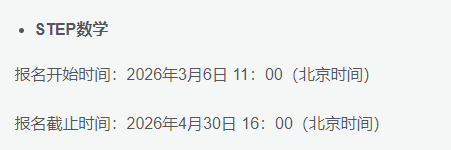

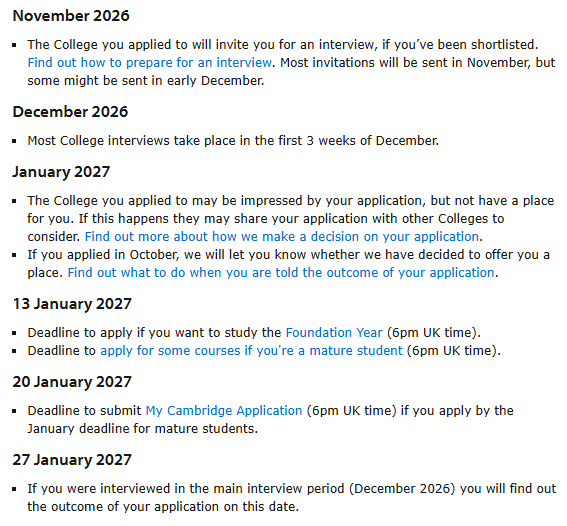

机器人科研项目