最近听到一则颇具震撼性的消息:Facebook 母公司 Meta 被曝正在收购 AI 新创公司 Manus。

据多方消息称,扎克伯格正加速布局人工智能领域,此次并购金额或高达 20 亿美元,而 Manus 作为一家具有中国背景的 AI 初创公司,也因此进入全球科技巨头的核心视野。

如果该交易最终落地,这很可能成为美国大型科技公司首次系统性收购亚洲 AI 创业生态的重要案例之一,其象征意义不亚于一次技术与地缘创新版图的重构。

2025 年,AI 正在全面开花。

而这股浪潮,终将深刻影响教育——从学习方式、评估体系,到人才定义本身。

从申请季开始,我有很多家长和学生都和我聊过关于美国高校会不会用AI审查文书的问题。我想,这也是AI爆发时代家长非常关心的一个问题,毕竟大家在生活中,或多或少都会用到AI。

实际上,过去两年AI在高等教育领域的存在感正以惊人的速度增强。从日常作业的查重、毕业论文的AI检测,到招生环节的文书审查与申请材料初筛,越来越多高校开始将AI工具引入核心流程。

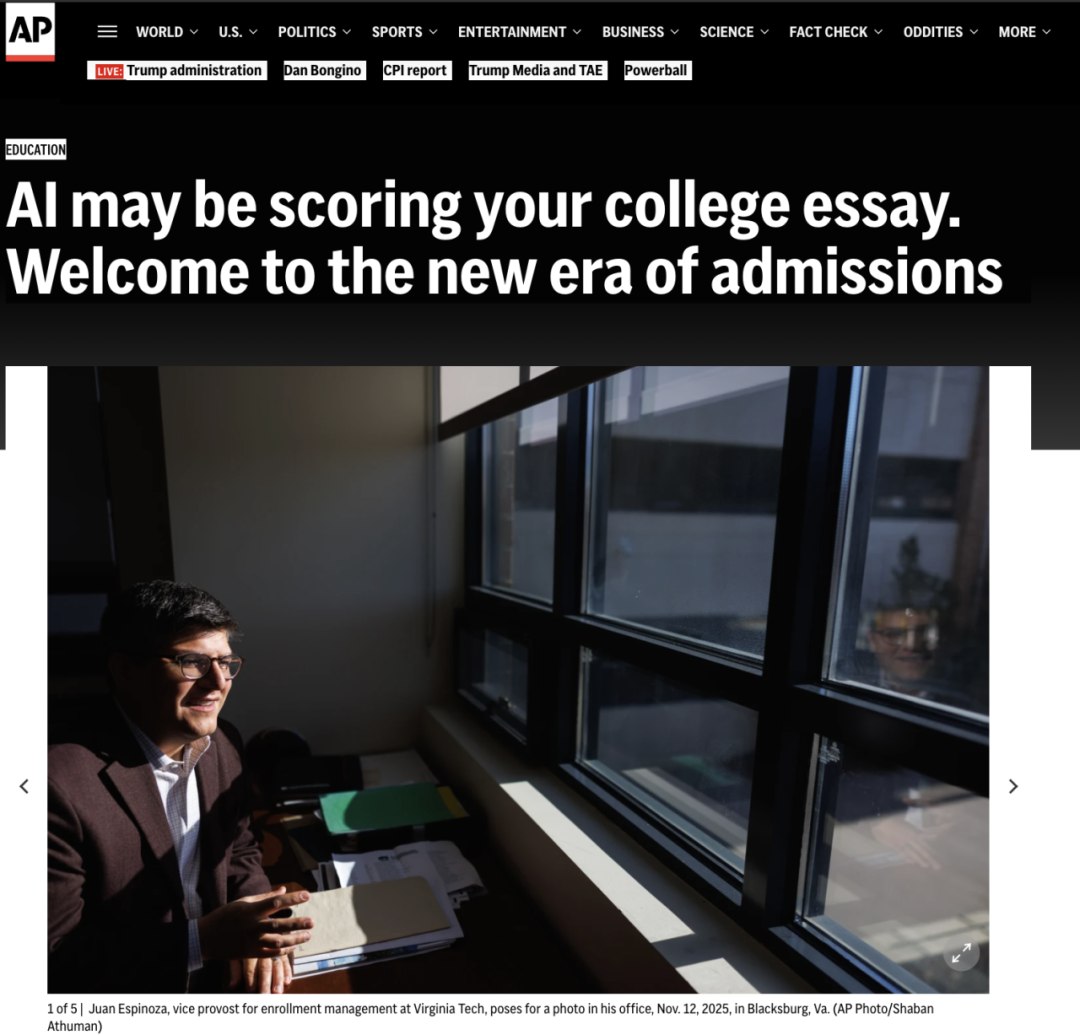

AP News 报道确认:一些美国高校正在将 AI 工具纳入招生审查流程,即便学校对外谈论这个话题相对谨慎。

校方给出的理由通常理性且务实:维护学术诚信、提高审核效率。在申请人数攀升、审查周期压缩的现实背景下,这种技术介入看起来合理且不可避免。

然而,在这场由算法驱动的效率革命阴影下,让我担忧的却是事实的另外一面:AI已然成为事实上的“准裁判”,但其审判的标准却是一片真空,而焦虑的家长和孩子却慢慢被ai检测掏空了钱包......

被算法悄悄排序的申请

我最近关注了很多美国大学有关AI审查的新闻报道,我发现即便多数高校强调“录取决定始终由人做出”,但外媒如《大西洋月刊》早已指出,我们正进入一个“黑箱录取”(Black Box Admissions)时代。

以弗吉尼亚理工大学(Virginia Tech)为例,学校已明确在招生中引入AI工具进行初步分析和排序。这意味着,在人类招生官读到你的文书之前,算法已经根据某种不透明的权重对你进行了分档。

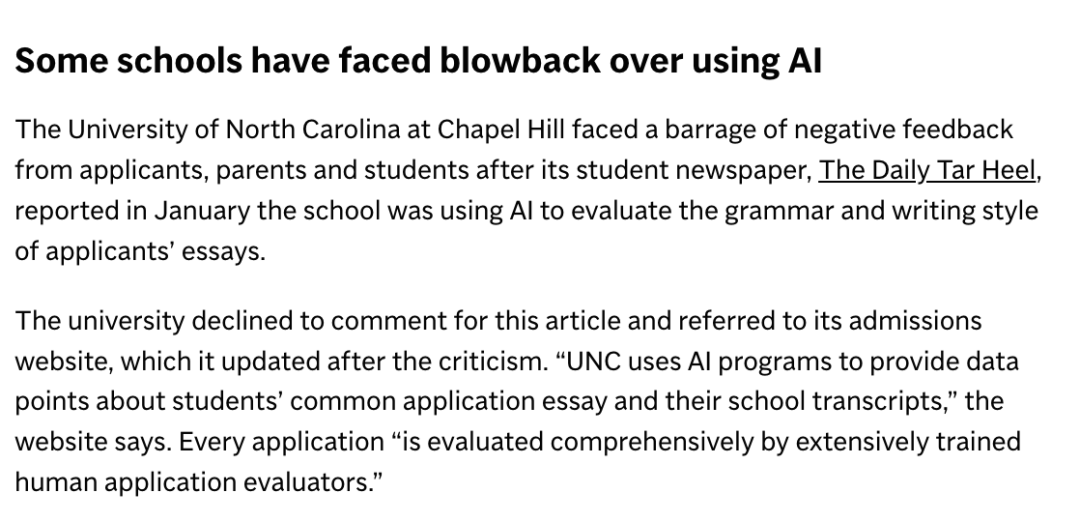

而北卡罗来纳大学教堂山分校(UNC)则开始利用AI评估文书的写作特征与质量。👇

新闻来源:https://apnews.com/article/ai-chatgpt-college-admissions-essays-87802788683ca4831bf1390078147a6f

但是学校却并没有公布他们使用何种模型对学生的申请进行评估,在这种权力极度不对称的博弈中,潜在的技术误差的后果被完全转嫁给了学生。

当一名学生被标记为“疑似AI”时,他面临的是现代公正体系中最难的逻辑题:举证责任倒置。在法律原则上,应由学校证明学生作弊;但在现实中,学生必须通过各种手段证明自己“没有做过某事”。

谁在定义“人类写作”?

高校对学术诚信的坚守无可厚非,但引发深层担忧的却是事实的另外一面:校方在严厉禁止AI代写的同时,却未能同步构建起一套公开、透明且科学的判定标准。

目前的学术界正陷入一种荒诞的“黑箱状态”:学生被严格要求证明自己是“人类”,却得不到任何关于判定的量化标尺:

高校究竟引进了哪家供应商的工具?

判定违规的“AI率”阈值是多少?

AI的误差后果由谁来承担?如何申诉?

这些关键信息始终被锁在黑箱之中。当校方对这些信息闭口不谈时,规则就变成了一种随意的、不可预测的行政威慑。

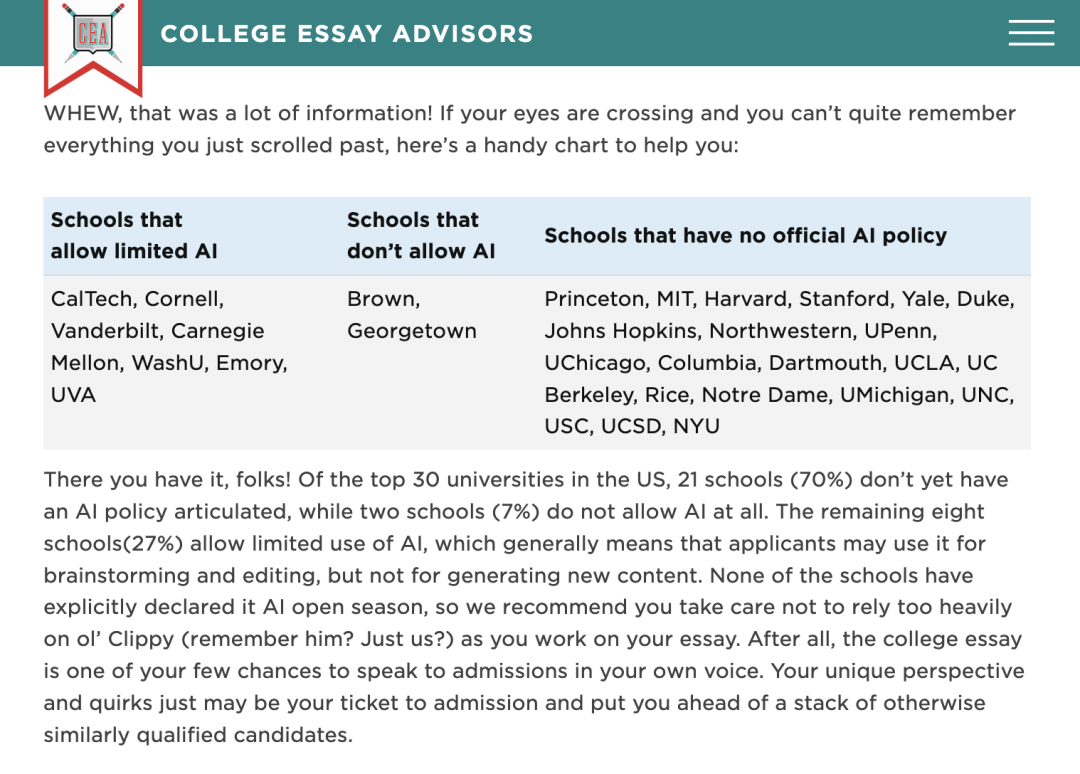

一项针对美国前30名大学的调查显示,约70%的学校至今没有正式的AI政策。这种技术应用大面积扩散、制度规范却极度匮乏的现状,让AI变成了一个无法核实、也难以质询的权力黑箱。

算法的逻辑原罪:为何“好学生”更容易被误伤?

这种标准的缺失,在面对AI检测的技术局限时,演变成了实质性的不公。

首先我们需要理解AI检测器的底层逻辑:它们主要通过测量文本的“困惑度”(Perplexity)和“突发性”(Burstiness)来下结论。AI生成的文本通常用词平稳(低困惑度)、句式均匀(低突发性)。

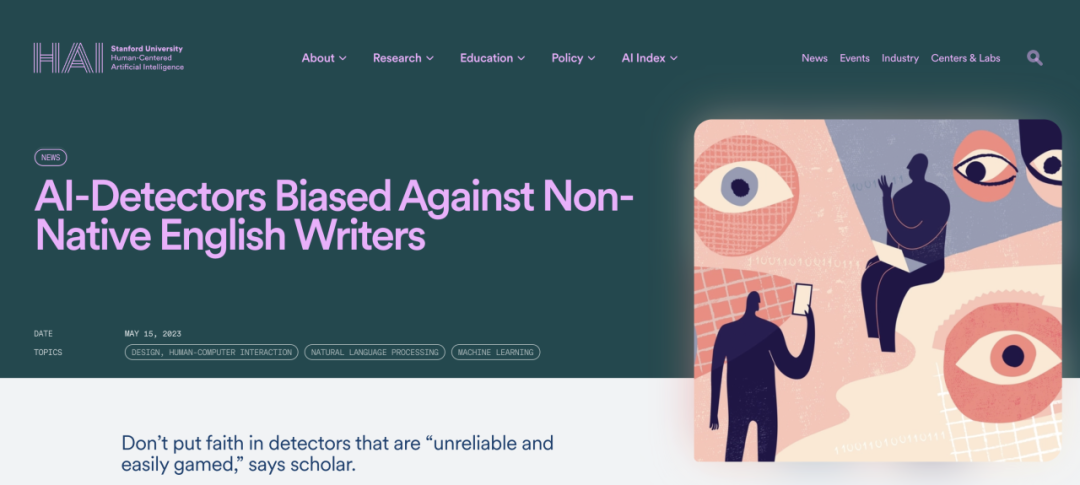

然而,这种判定逻辑存在天然的弊端。斯坦福大学的一项核心研究("GPT detectors are biased against non-native English writers")揭示了一个惊人的事实:主流AI检测器对非母语写作者存在严重的系统性偏见。

报道原文:https://hai.stanford.edu/news/ai-detectors-biased-against-non-native-english-writers

研究显示,非母语学生为了确保表达准确,往往倾向于使用规范、简洁、高度标准化的句式。讽刺的是,这种受过良好学术训练、稳健的写作特征,在算法眼中恰恰具有了机器生成的低困惑度特征。

在测试中,超过一半的非母语者作文被误标记为AI生成,误报率甚至一度高达91%。这意味着,学生表现得越像“受过良好训练的学生”,被标记为AI的风险反而越高。这种技术弊端,让留学生们呕心沥血打磨的文字,在算法面前成了无法自证清白的“呈堂证供”。

收割焦虑与转嫁风险

在这条“算法诚信”的产业链中,各方的处境构成了极度不公平的图景。

首先是AI技术提供商,他们是这场“焦虑经济”中最大的获益者。这些公司以“风险控制”为卖点,建立起稳定的付费模式。

他们利用高校对舞弊的恐惧套现,获取了海量数据,却无需为任何一个因误判而改变的学生命运承担责任。

高校通过外包审核权力获得了效率红利,缓解了行政压力,但长期看来,却必然面临着公众和潜在候选人对其审查公信力的质疑。

而处于食物链最末端的学生,则在承担更多风险。为了逃离算法的“误伤区”,焦虑的家长和学生只能通过给各类商业检测平台一遍又一遍地支付昂贵的检测费用,甚至为了迎合检测器的“审美”而刻意扭曲自然的写作风格。这种行为,本质上是在为教育制度的透明度缺失缴纳一笔沉重的“诚信赎金”。

我认为AI 进入教育审查体系本身并非问题,技术的发展原本也可以成为提升效率与公平的工具。

但真正值得警惕的,是当判断逐渐交由算法完成,而相关制度却未能同步建立起足够清晰的边界、透明的制度和有效的纠错机制。

教育的核心仍然是对个体能力、潜力与成长轨迹的理解。如果 AI 注定要参与到这一过程中,我认为高校最低限度的回应也应当包括:明确 AI 的使用范围与角色、必要的信息披露、可行的申诉与复核机制,以及对误判风险的合理分担。

只有在这些条件之下,技术才能真正服务于教育,而不是替代制度本应承担的判断责任。

否则,当学生为了避免被误判而反复自证清白、刻意调整自然的表达方式,去迎合算法所偏好的“安全写作”,被影响的就不仅是某一篇文书的呈现方式,而是整个教育体系对真实、原创与信任的理解。

技术可以不断进步,但关于公平与责任的判断,仍应牢牢掌握在清晰的制度与可被追问的人类决策之中。