一个机器学习工程师发推特说:“这太疯狂了!”一家专注于人工智能新闻的账号称这是一项“开创性的研究”。这项研究声称,ChatGPT能够以100%的准确率完成麻省理工学院的数学、计算机科学和电气工程本科课程。

它每个问题都答对了。

这项研究于6月中旬发布,是一篇未经同行评审的预印本。但它有15位作者,其中包括几位麻省理工学院的教授。研究中有着彩色编码的图表和充满统计数据的表格。考虑到最近几个月聊天机器人表现出的无所不知的能力,AI能够毕业于麻省理工学院似乎并不完全不可思议。

然而,就在发布后不久,三位麻省理工学院的学生仔细研究了这项研究的方法以及作者用来得出结论的数据。

他们对发现的内容感到“惊讶和失望”,发现存在“明显的问题”,据他们看来,这意味着ChatGPT通过欺骗的方式顺利通过了麻省理工学院的课程。他们把他们详细的批评命名为“不,GPT4并不能在麻省理工学院表现出色”,并加了一个捂脸的表情符号以强调他们的评估。

刚开始的时候,这篇研究似乎是记录人工智能快速进展的一个里程碑,但在这些学生揭露的事实面前,它更像是一种尴尬,或者说是一个警示。

其中一位学生Neil Deshmukh在阅读论文时持怀疑态度。他怀疑ChatGPT是否真能应对麻省理工学院的课程,考完所有的期中和期末考,而且还完美无瑕地完成。Deshmukh在一个对机器学习感兴趣的麻省理工学院学生的群聊中分享了论文链接。另一位学生Raunak Chowdhuri阅读了论文后立刻发现了一些警示信号。他提议他和Deshmukh一起撰写关于他们担忧的内容。

他们两人和第三位学生David Koplow开始深入研究研究结果,并通过短信互相交流他们的发现。一个小时后,他们对研究的方法论产生了怀疑。两个小时后,他们对数据本身产生了怀疑。

首先,他们发现一些问题根本无法在作者提供的信息下得出答案,因为上下文信息太少了。还有一些所谓的“问题”根本不是问题,而只是作业而已:ChatGPT如何完成这些作业,按照什么标准进行评分?学生们写道:“要么是答案在提示中泄漏了,要么是这些问题的评分不正确。”

这项研究使用了所谓的few-shot prompting技术,这是训练像ChatGPT这样的大型语言模型执行任务时常用的技术。这个技术涉及向聊天机器人展示多个示例,以使其更好地理解任务要求。在这种情况下,多个示例与答案本身非常相似,他们写道,就像“一个学生在考试前被告知答案然后再参加考试”。

他们在一个星期五的下午开始撰写批评,一直忙到深夜。他们反复检查自己的发现,担心自己可能误解了或对论文的作者们不公平,其中一些作者是他们的同学,还有一些是他们所就读大学的教授。“我们真的无法想象列出的15位作者会忽略所有这些问题,”Chowdhuri说道。

他们发布了批评并等待反应。这三人很快就被通知和祝贺信息淹没。他们的批评链接发表的推文获得了超过3000个赞,引起了包括人工智能知名学者Yann LeCun在内的高知名度学者的关注,后者被认为是AI的“教父”之一。

对于论文的作者们来说,这样的关注并不受欢迎,他们急于弄清楚出了什么问题。其中一位作者是MIT的电气工程和计算机科学系教授、该校计算机科学和人工智能实验室的副主任Armando Solar-Lezama。他说他不知道论文会作为预印本发布。此外,他也不知道有人声称ChatGPT能在麻省理工学院的本科课程中表现出色。他称这个想法是“荒谬的”。

虽然ChatGPT在某些方面表现出色,但它并不是一个全能的系统。

学生们的批评揭示了ChatGPT在处理复杂问题和详细信息方面的局限性。尽管人工智能在某些领域取得了巨大进展,但它仍然远远落后于人类在理解和创造方面的能力。

这两年来,ChatGPT的突然出现引起了全球范围内的轩然大波,人们对它的态度不一。

ChatGPT凭借其出色的AI技术受到了全球年轻人的热爱。它拥有多样化的功能,可以帮助节省查阅复杂文献的时间,编写简单的Python代码,辅助学生理解知识点等等。

然而,ChatGPT也引发了学术诚信问题,让各大学纠结不已。

英国各大学数月来一直在讨论是否允许学生在完成课业时使用ChatGPT。他们的态度各不相同:有的禁止使用,有的允许作为辅助工具(如UCL),还有一些没有明确表态。

据报道,牛津大学、剑桥大学、曼彻斯特大学、布里斯托大学和爱丁堡大学等多所大学曾出台规定,禁止学生使用ChatGPT来写作业。

之前,英国大学已经出现了首例学生因使用ChatGPT而挂科的情况。

根据英国媒体的报道,一位英国博尔顿大学的学生写了一篇关于"领导理论及其在实际中的运用"的论文。

大学的调查文件显示,他们认为该论文使用了ChatGPT的原因有以下四点:

- 写作风格不一致论文的理论部分和实践部分的写作风格存在明显差异。

- 无意义的陈述论文中大量的主题思想和实践部分的陈述缺乏意义。

- 引用晦涩的参考文献论文的参考文献只引用了两篇可以在大学系统上访问的期刊文章,而没有引用任何大学提供的阅读清单。然而,论文却引用了一篇于1952年发表的鲜为人知的博士论文《衡量工业领导力及其对培训主管的影响》,以及一篇于1957年的期刊文章。

- 引用巫师和女巫书籍最后,论文还引用了一本神话书籍《巫师和女巫的领导力见解:通过流行文化探索有效的领导力实践》。这本书是关于J.K.罗琳笔下的魔法世界的,去年5月出版,售价只需20英镑,可以从亚马逊购买。而进一步发展的ChatGPT-4现在已经可以引用这本更新的书籍了。

最终大学的调查发现,该学生是从代写机构购买的论文,所以可能是代写机构使用了ChatGPT来完成论文。

而除了人工判定ChatGPT在论文中的使用痕迹,现在也有软件可以帮大学进行检测了。

上个月,Turnitin正式推出可以检测“学生在论文或作业中使用ChatGPT“的系统,并声称检查结果的可信度高达98%。

*图片源自网络

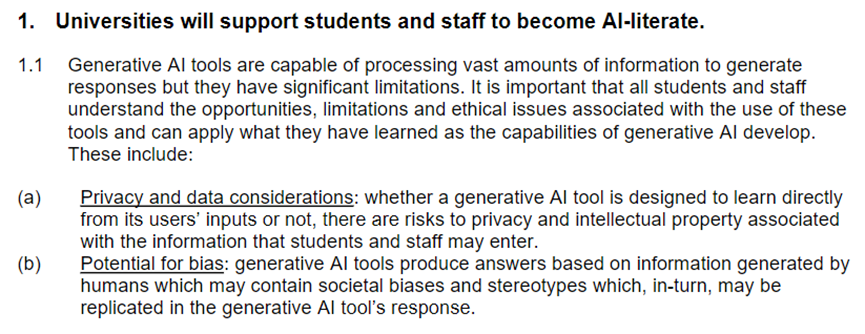

目前,罗素大学发布的ChatGPT使用规则如下。1. 大学将帮助学生和教职员工了解人工智能:

*图片源自网络

2. 教职员工应有能力帮助学生正确使用生成式人工智能工具:

*图片源自网络

3. 大学将调整教学和评估,以纳入使用人工智能的道德标准,并确保平等使用人工智能:

*图片源自网络

4. 大学将确保学术诚信得到维护:

*图片源自网络

5. 随着AI在教育中的应用深入,大学之间将合作、分享最佳实践:

*图片源自网络

使用ChatGPT生成的文章可能会以华丽、精致的语言呈现,但却缺乏个人特色和独特的记忆点。

另外,虽然人工智能能够撰写出不错的申请文章,但它缺乏主观性和真实感,仅仅依赖互联网上的已知数据。这使得很难向教授展示你的真实情感、细节和个人特点,无法让他们真正了解你的个性和潜力。

最重要的是,无论是国内还是国外的大学,学术诚信都是至关重要的原则,是绝对不能触犯的底线。此外,目前存在多种检测工具可以识别由ChatGPT生成的内容。因此,一旦学校进行检测,你所提交的论文将被识别出来,申请过程中的一切努力都将付诸东流。

因此,我们应该珍惜学术诚信,坚持通过自己的努力和真实的表达来撰写申请文书,展示真实的自我和独特的价值。