ChatGPT、Claude、Gemini、文心一言……AI已经走进科研和写作的日常。可是不少学者心里也有一个疑问:

“如果我把论文、实验数据输入到AI里,会不会泄露?”

这个问题——很有必要认真聊一聊。

通用大模型的工作原理决定了

它“看得见”你的内容

通用AI模型(例如ChatGPT、Claude等)通常在云端运行。这也就是说:你输入的每一句文字,实际上都被发送到了服务器上,由模型读取、理解、生成回答。

这听起来没问题,但从数据安全的角度看就意味着:

1.输入内容可能被用于模型再训练有些AI服务会保留用户输入,用于后续的模型微调。如果输入的是论文段落、实验数据、尚未公开的成果,未来极少数情况下可能被模型“学习”并在别的回答中“复述”。

2. 输入日志会被系统记录通用AI系统会保存使用日志,以便改进模型或排查故障。这些日志并非对外公开,但一旦安全策略不严,就可能带来风险。

3. 插件和外部API存在潜在风险一些AI集成了搜索、PDF阅读或图像生成等功能,如果这些插件调用了外部服务,也可能导致内容被间接传输或缓存。

换句话说:即使你删除聊天记录,AI的“记忆”有时也可能仍留在系统深处。

而科研、论文写作与普通AI聊天最大的不同在于:内容往往包含尚未公开的研究数据、合作项目、甚至知识产权信息。一旦这些内容被AI系统保存、调取、或误用,将造成严重后果!因此科研写作场景需要更高等级的安全防护。

科研专属AI工具是更安全的选择

以 Paperpal 为例,它采用的是“安全优先(Secure-by-Design)”架构:

· Paperpal从不使用用户数据训练模型

· 所有数据存储在 SSAE18 / SOC1 认证的安全设施中

· 传输与存储全过程加密(256位加密 + KMS密钥)

· 按照欧盟通用数据保护条例 (GDPR) 运营

· 遵守隐私和电子通信条例 (PECR),也称为电子隐私指令

· Paperpal的信息安全管理系统 (ISMS) 已通过 ISO/IEC 27001:2013 国际标准认证

· Paperpal在云安全联盟的安全、信任、保证和风险 (STAR) 注册表中被列为 1 级

简而言之,Paperpal 不仅仅是写作助手,更是一个符合科研伦理与数据安全标准的学术AI伙伴。

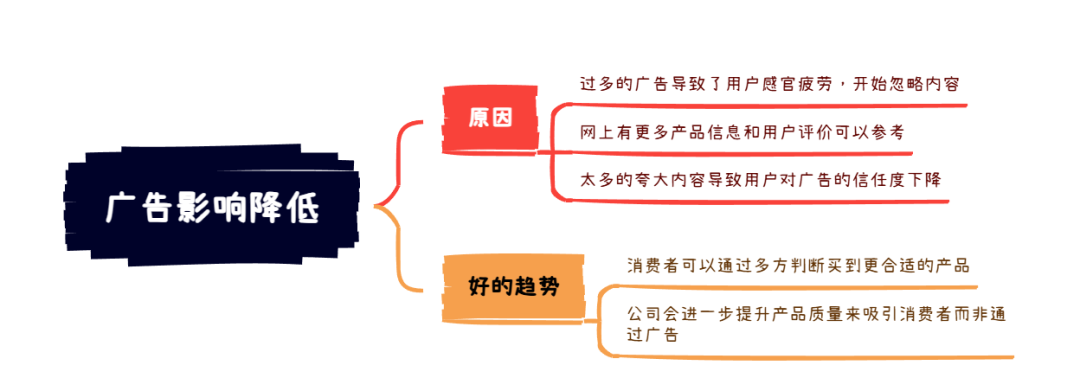

通用大模型AI能帮你生成灵感、优化语句、解释概念。但在科研写作中,它不一定是最安全的选择。

如果你在处理学术论文、项目报告或尚未发表的数据,请务必选择像Paperpal这样为科研定制、具备隐私保护机制的AI工具。

毕竟,创新值得保护,数据安全也是科研的一部分。