这几年,关于大学申请的最大变化之一,就是“人”不再是唯一的评审者了。

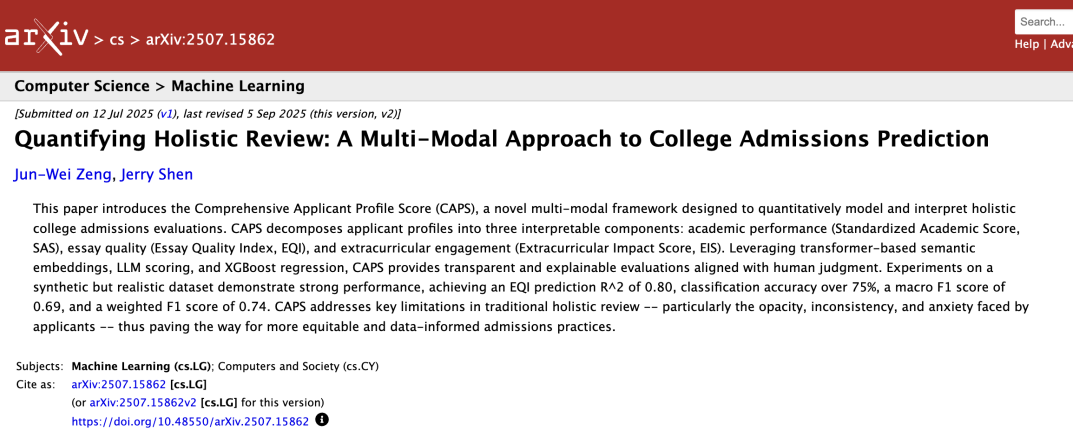

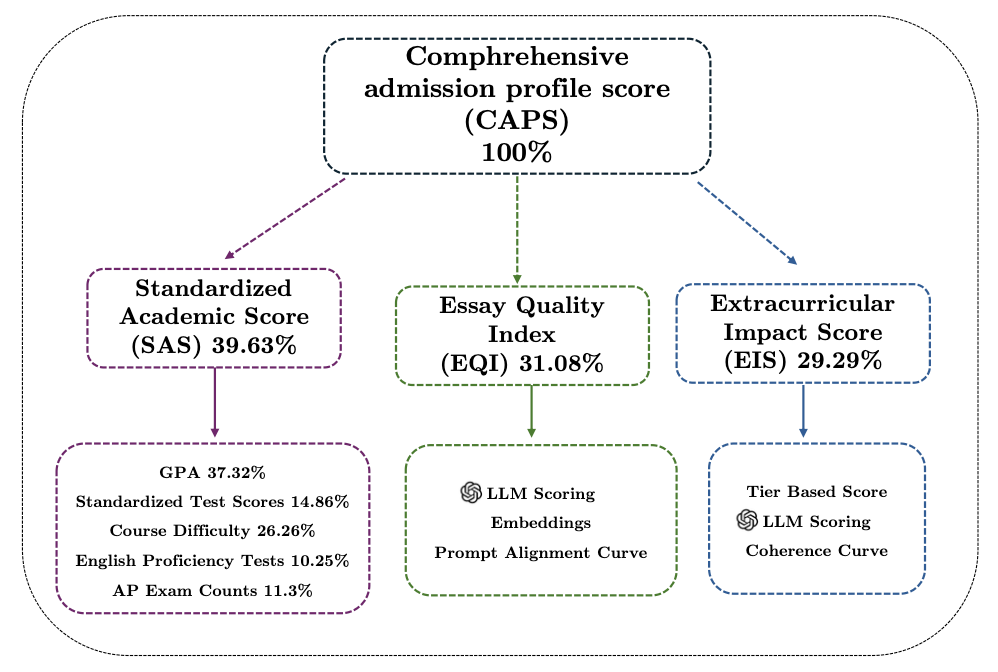

最近发布在 arXiv 的一篇预印本论文《Quantifying Holistic Review: A Multi‑Modal Approach to College Admissions Prediction》提出了一个新的录取评估框架:CAPS模型(Comprehensive Applicant Profile Score)。

它尝试用机器学习的方式,把传统“全面评估”(holistic review)中那些看似无法量化的因素,比如文书、课外活动、个人背景,全部拆解成三大模块,再融合打分,得出一个最终的“综合申请评分”。

听起来像是把招生官的主观判断交给了一个“透明的AI评分系统”——但这真的是未来大学招生的终局么?我们今天就来拆解一下这个模型到底做了什么、效果如何、问题在哪,以及对未来申请者意味着什么。

CAPS 模型是什么?

Holistic Review 一直是美国大学申请的基石,但它最大的问题就是:主观性强 + 不透明。

招生官如何读一篇文书、怎么看一个活动、怎么比对两个“都不错”的申请者,向来没有统一标准。

CAPS 提出的就是一个“系统性量化框架”:

把申请者的整体档案,拆成三块、分别打分、再融合预测。

CAPS 是“Comprehensive Applicant Profile Score”的缩写,直译为“综合申请者档案评分”。研究者的目标是:构建一个可以量化所有关键申请材料的评分体系,然后借助机器学习来做预测和排序,辅助录取判断。

它包含三个可解释子模块:

- SAS(Standardized Academic Score)

整合了五类学术指标:

它使用 Z-score 标准化处理,之后用主成分分析(PCA)提炼这五个维度间的“潜在结构”,并结合招生专家手动权重,得出最终加权分数。

你在高中时修过哪些课?GPA多少?考了哪些标化考试?难度怎么样?都算。

模型会把这些数据统一处理,转成一个标准化的“学术能力评分”,范围是 0~100 分之间。

它不像人类招生官“主观判断难不难”,而是用历史数据和统计方法把你的课程难度、分数水平放进整体大样本里比较——你处在大概什么档位,一目了然。

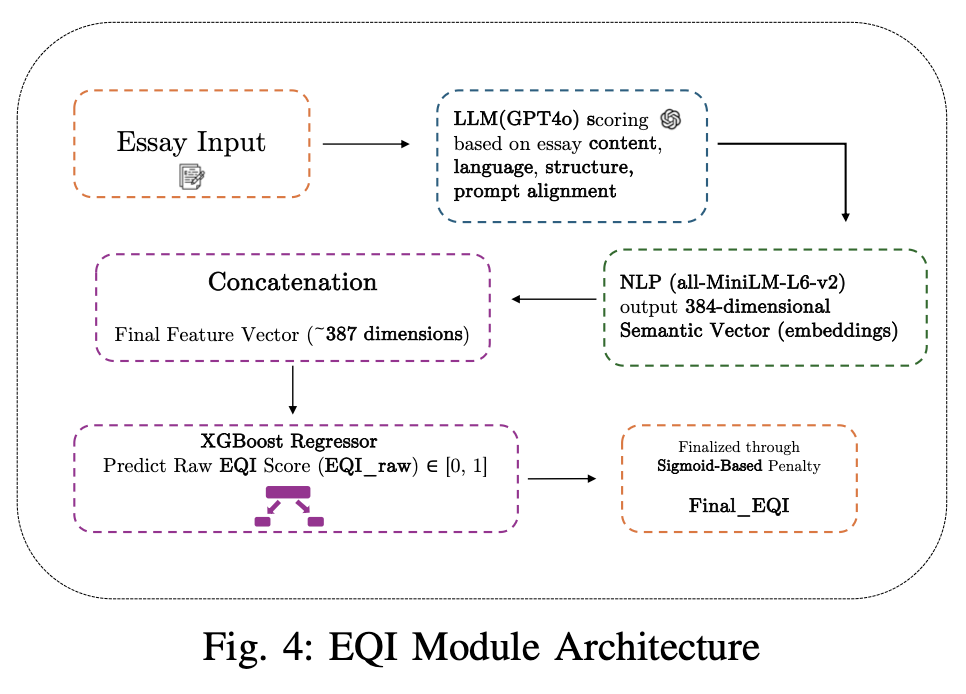

- EQI(Essay Quality Index)

EQI 模块可以理解为 CAPS 模型里最“神秘但强大”的部分。简单来说,它就是一套专门用来评估文书写得好不好的系统,但不是靠主观感受,而是AI在多个层面认真“读”你的文章。

评分分几个步骤:

先让 GPT-4o 打一个基础印象分:从“内容有没有深度”、“语言是否流畅自然”、“结构清不清晰”这三个方面打1到5分。

再把整篇文书转成一段 AI 能读懂的“数字语言”:也就是让模型感知语气、逻辑、用词等等看不见但能捕捉的特征。

然后用一个“预测模型”综合判断你这篇文书的大致水平,分数落在 0 到 1 之间,相当于它在申请者里属于哪一档。如果你文不对题,会被系统自动识别出来并“扣点分”。

最后,模型还会告诉你这篇文书是“赢”在内容、语言还是结构上,帮助你知道自己的强弱项。

整体来看,它既有“读”的理解力,也有“评”的判断力,不是在挑错,而是在理解你表达了什么之后再给分。

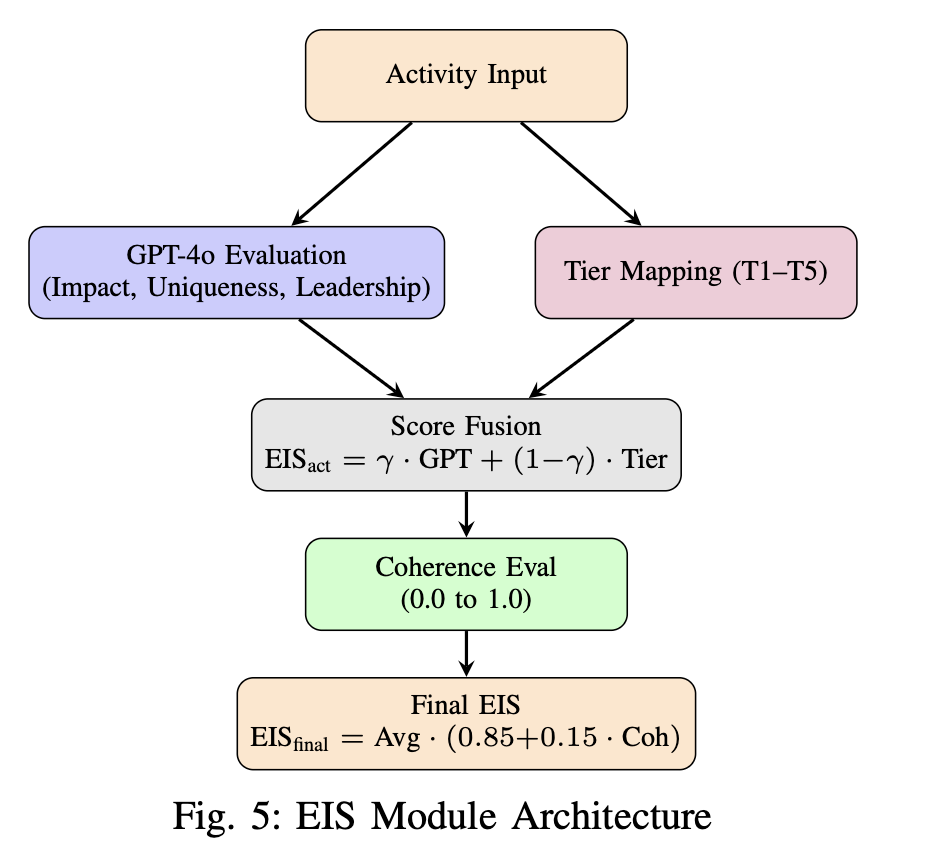

3. EIS(Extracurricular Impact Score)

活动评分也不再是“看上去厉害就加分”。

模型分两步来看你的活动背景:

第一步:给每个活动本身打分

影响力大不大?有没有领导力?是不是独特?AI 逐项给你每个活动打个 0–1 分的基础分。

第二步:判断你的“活动等级”

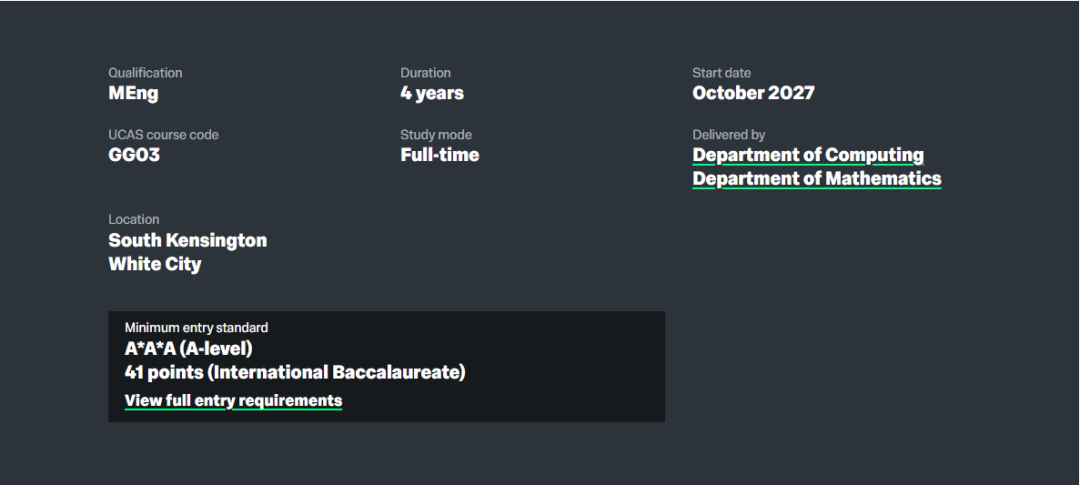

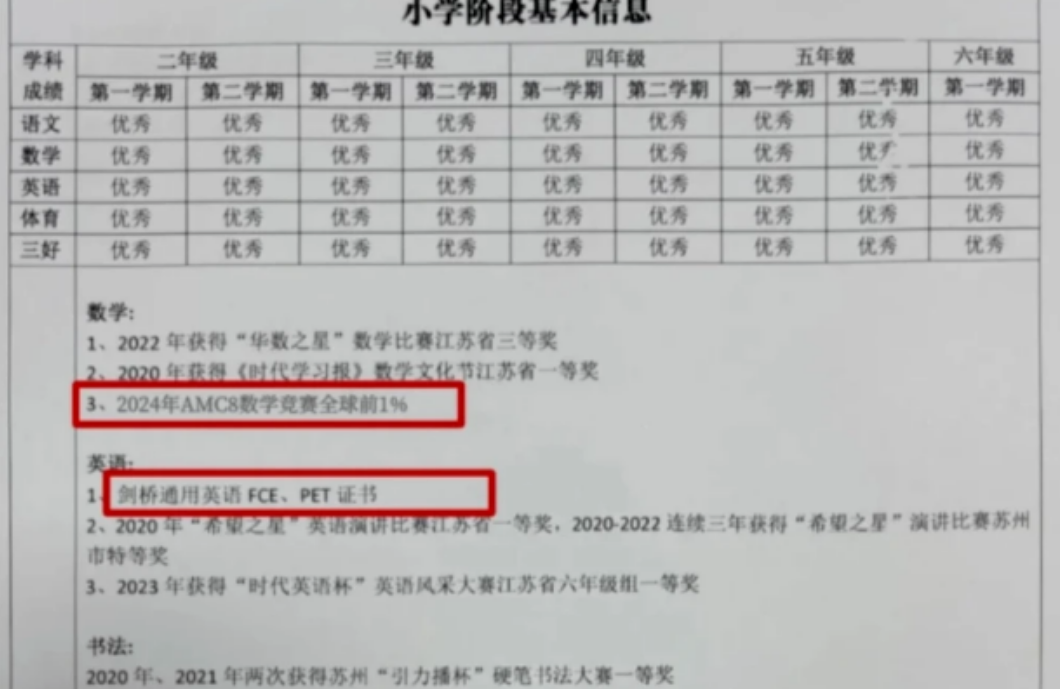

- T1:全国级别的领导或奖项(比如科研发表、竞赛拿金牌)

- T2:省/州级有成果

- T3:学校长期参与 + 组织者

- T4:普通成员参与

- T5:偶尔参与、时间短

每一项也会给一个等级分,比如 T1=1.0 分,T5=0.2 分。这两个分数会各占一半,融合出该项活动的最终得分。

然后,模型还会看你整体的活动有没有“主线”,比如是不是都围绕“教育平权”“科技兴趣”或“女性写作”展开。如果你的活动之间很杂、缺乏一致性,就会被适度扣分。

最终,所有活动合成一个 EIS 活动影响力得分(0–100),也进综合评估系统。

这些模块怎么组合起来的?

在三个模块(成绩、文书、活动)都打完分之后,模型会把这些分数“统一口径”,然后综合成一个总分——CAPS 分数(满分100分)。

不过,这个“综合”不是简单平均,而是一个“AI和专家共同投票”的过程。它会结合三种视角来决定每个部分的权重:

- Logistic回归 →理解成“线性平均”,看整体趋势。

- XGBoost模型 →让机器去捕捉更复杂的非线性关系,比如文书和活动之间的交叉影响。

- 专家经验加权 →招生官根据经验微调,比如文书和活动的重要性在某些学校更高。

三者各占一部分比重:30% + 30% + 40%,最终拼出一个“机器与人共同认可”的综合分数。

此外,模型还设计了一个“公平性调整”机制——对于弱势群体(比如少数族裔、LGBTQ+、农村学生、绿卡申请者等),系统会在最终分数中给予最高12分的额外加成,用来平衡结构性不平等,让评分更接近真实潜力而不是背景资源。

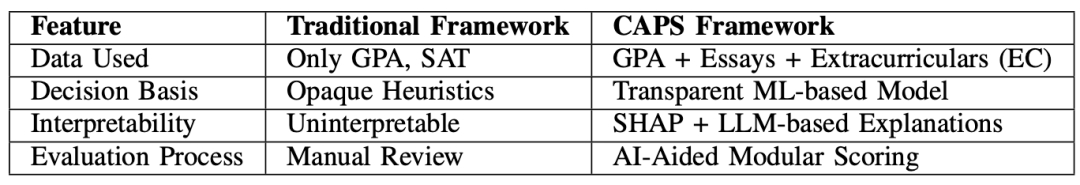

它和传统 holistic review有什么不同?

CAPS的思路,是在不完全放弃人工判断的前提下,用“机器可理解”的方式,把所有申请材料转成结构化信号,让机器也参与评分和排序。

同时,因为每个模块都能解释、权重可调,它避免了“黑箱AI”那种完全不知如何得分的恐惧感。

那这是不是意味着“以后全靠AI选人”?

研究团队明确说:不是。

CAPS的定位不是取代人工,而是辅助和对齐。

他们建议的应用方式包括:

- 招生官在评审前先看 CAPS 模型的初步打分和风险提醒

- 招生官根据模型提示重点关注“材料冲突”或“潜力未被看到”的申请者

- 降低人工评分分歧带来的录取混乱

CAPS 本质上是一个“可解释、高效率、补盲区”的工具,而不是裁定录取与否的AI法官。

这个模型真的靠谱吗?

那我们作为申请者,需要担心吗?

不必恐慌,但要警觉。以下是几个建议:

✅ 写作和表达永远是硬通货

AI 不会喜欢格式作文,但会喜欢逻辑清晰、有语义密度、有独特视角的表达。打磨你的表达能力,不仅是“骗分”,更是“避免被低估”。

✅ 活动不要堆数量,要做“高信号事件”

模型比人更擅长识别“真实有影响力”的行为模式。选项目的时候别想着刷表格,要做真事、有结果、能讲故事。

✅ 学业难度在成为加分项

课程挑战度、AP加载量等可能进入SAS模块。选课策略要注意“长线提升”。

✅ 保持人性

再聪明的模型也看不到你哭过、失败过、熬夜学某个课的过程。别放弃在文书里讲出“你是谁”,模型只是工具,永远无法完全替代人。

未来,我们可能看到越来越多高校用类似模型做排序、筛选或参考,尤其是面对几十万份申请的时候。

你不必成为“模型最爱”的申请人,但你至少得知道“它在看什么”。写文书不是为了“骗机器”,做项目也不是为了“让AI加分”。

而是,你始终知道:如果世界开始用某种方式评价你,那你要比它更早、更清楚地看见你自己。